Wikipedia ha interrotto in meno di 24 ore il progetto pilota che doveva introdurre riassunti automatici creati dall’intelligenza artificiale in cima ai suoi articoli. L’esperimento, avviato il 2 giugno 2025, ha subito incontrato forti opposizioni da parte degli editor esterni, cioè i volontari che collaborano quotidianamente alla gestione dei contenuti della piattaforma. I timori riguardano soprattutto la possibile perdita di affidabilità dell’enciclopedia online e la mancanza di coinvolgimento di questi collaboratori nella fase di progettazione della novità.

La sperimentazione dei riassunti ai tempi dell’intelligenza artificiale

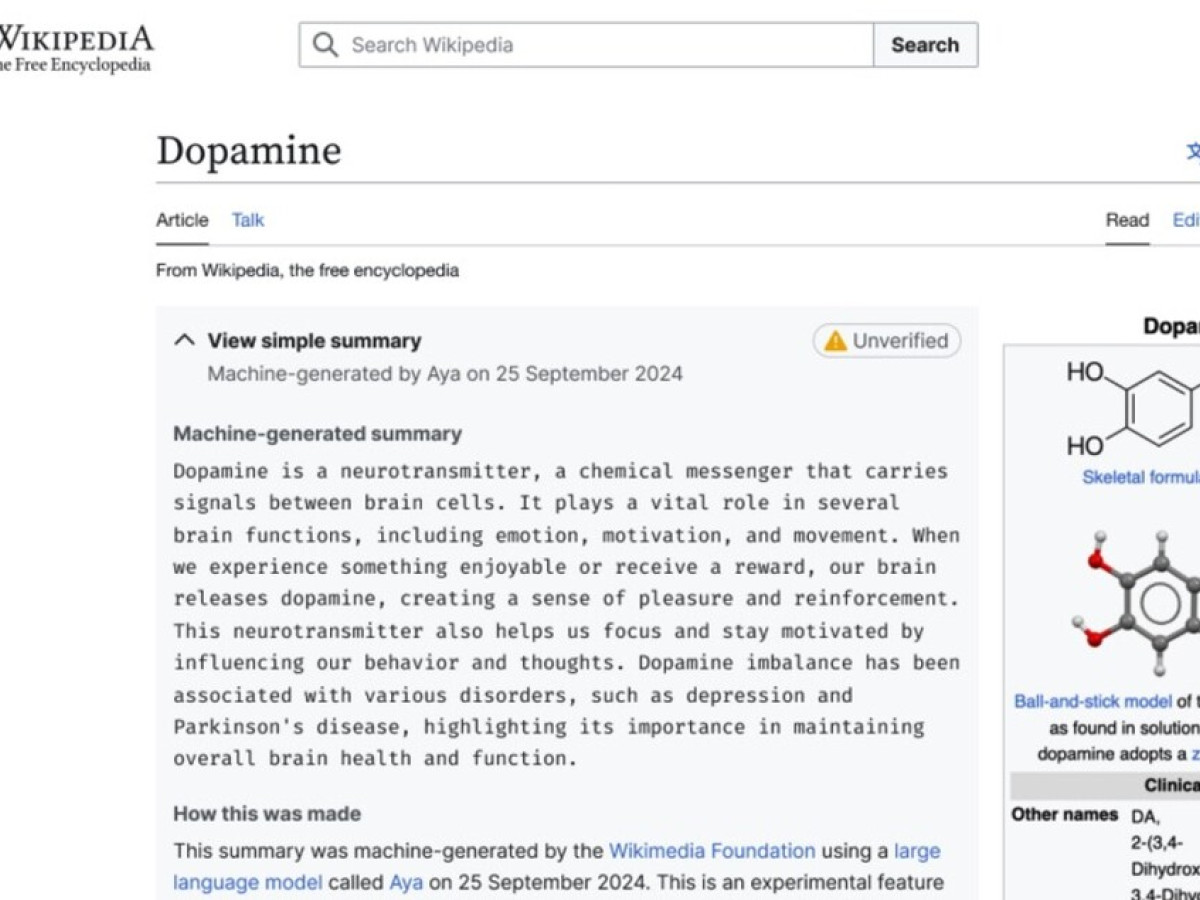

Wikipedia ha annunciato di voler inserire riassunti generati dall’intelligenza artificiale nella parte superiore delle pagine, con un’etichetta gialla che avvisava gli utenti sulla natura “non verificata” dei testi. Il tentativo mirava a fornire sintesi immediate degli argomenti, espandibili su richiesta del lettore. L’idea, però, si è scontrata presto con le difficoltà legate alla qualità delle informazioni offerte dall’intelligenza artificiale.

Il test non è durato abbastanza da raccogliere dati significativi, stoppato appena il giorno dopo il lancio. Nonostante la potenzialità di semplificare l’accesso al sapere, il progetto si è scontrato con l’importanza di mantenere l’affidabilità, che Wikipedia rappresenta per milioni di utenti. La presenza dell’etichetta gialla non ha sufficiente garantito la fiducia degli editor, preoccupati che riassunti inesatti potessero confondere o disinformare.

Le critiche degli editor e i rischi per la credibilità di Wikipedia

Gli editor hanno alzato subito la voce. Una delle principali preoccupazioni riguarda le cosiddette “allucinazioni” dell’intelligenza artificiale: errori nei contenuti generati che possono sembrare convincenti ma sono in realtà falsi o distorti. È un problema noto anche al mondo tecnologico: TechCrunch, rivista specializzata, ha evidenziato che i riassunti automatici spesso contengono imprecisioni difficili da rilevare a colpo d’occhio.

Opinione di un editor

Un editor ha scritto chiaramente che seguire l’esempio di giganti come Google non significa copiarne in modo acritico le opzioni, specialmente su una piattaforma che basa la sua reputazione sulla verifica accurata. L’ingresso dell’IA in Wikipedia ha anche scatenato paure più profonde: gli editor si sono sentiti esclusi nel processo decisionale e hanno messo in guardia dall’impatto duraturo che queste innovazioni potrebbero avere sulla percezione del sito, a rischio di danneggiare l’immagine di fonte seria e attendibile.

La reazione della Wikimedia Foundation e la sospensione del progetto

All’indomani della sperimentazione, la Wikimedia Foundation ha confermato la sospensione del progetto ribadendo l’importanza del dialogo con la comunità di volontari. Un portavoce ha spiegato che i feedback ricevuti dagli editor hanno spinto a tornare indietro e modificare la strategia. La piattaforma vuole mantenere un carattere collaborativo, dove ogni novità è discussa e valutata con chi contribuisce attivamente a costruire e mantenere il contenuto.

Riflessioni sull’intelligenza artificiale e la verifica

Il caso di questi riassunti evidenzia la complessità dell’introduzione dell’intelligenza artificiale in contesti in cui la verifica e la qualità sono essenziali. Wikipedia ha aperto una discussione che coinvolge tutto il mondo dell’informazione digitale. Anche se il progetto è stato congelato, resta viva l’attenzione sulle potenzialità e i limiti dell’IA. Non mancheranno nuovi tentativi di integrare queste tecnologie, ma sempre tenendo conto dell’opinione della comunità che sostiene la piattaforma da oltre vent’anni.

Ultimo aggiornamento il 16 Giugno 2025 da Andrea Ricci