Wikipedia ha interrotto in fretta il test dei riassunti automatici generati dall’intelligenza artificiale, dopo le forti critiche degli editor volontari.

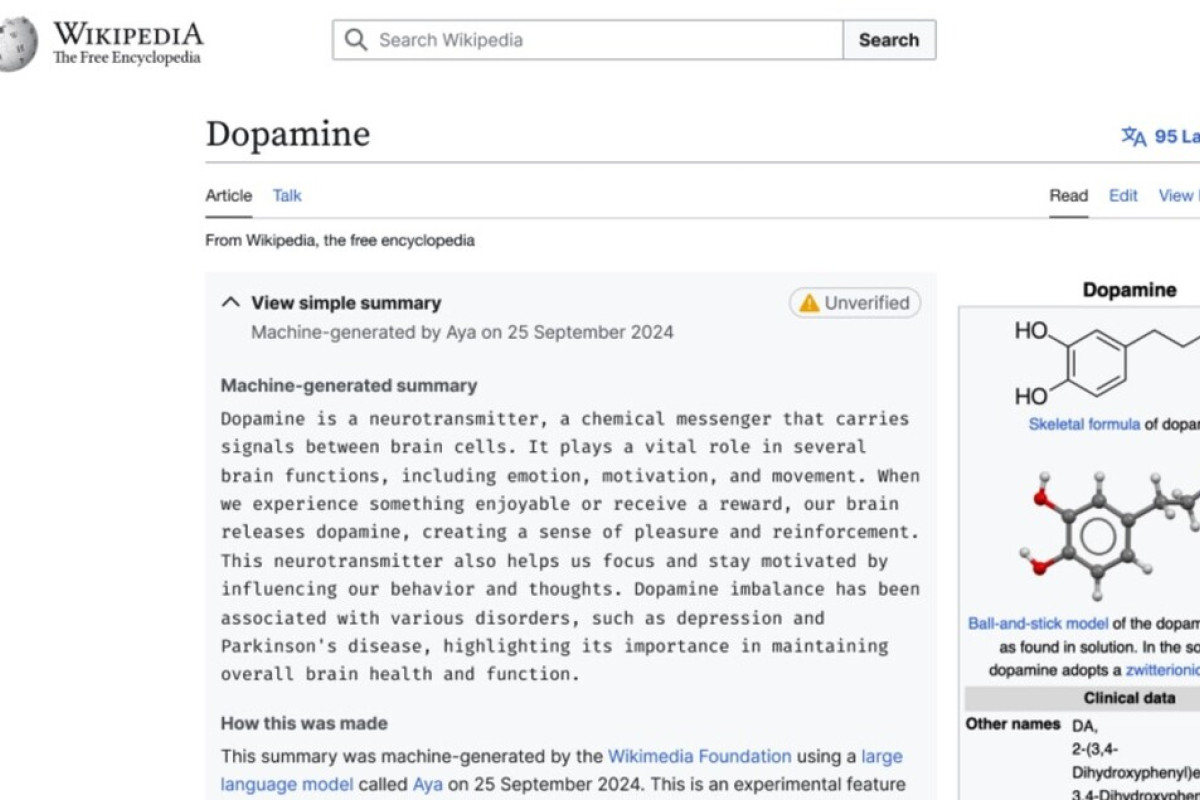

All’inizio di giugno 2025, Wikipedia ha lanciato un esperimento piuttosto ambizioso: inserire in cima agli articoli dei riassunti creati da un’intelligenza artificiale. Questi brevi testi venivano mostrati con un’etichetta gialla “non verificato”, per avvisare gli utenti che si trattava di contenuti generati automaticamente e non ancora controllati.

L’idea era semplice: aiutare chi legge a farsi subito un’idea generale dell’argomento senza dover scorrere tutto l’articolo. Per leggere il riassunto completo, bastava cliccare sull’etichetta e il testo si espandeva.

La reazione immediata degli editor: una bomba di critiche

Non è passato molto prima che gli editor esterni, cioè i volontari che scrivono e aggiornano Wikipedia, si facessero sentire. Hanno espresso preoccupazioni forti sul progetto. Il timore principale? Che questi riassunti automatici potessero minare la credibilità della piattaforma.

Gli errori nei testi prodotti dall’IA sono noti come “allucinazioni”: informazioni sbagliate o inventate senza controllo. Techcrunch, sito specializzato in tecnologia, ha sottolineato proprio questo problema, spiegando che spesso i riassunti AI contengono imprecisioni.

Un editor ha scritto sotto l’annuncio ufficiale: “Solo perché Google usa riassunti basati su IA non significa che dobbiamo farlo anche noi. Vi prego di non testarli né su mobile né altrove. Questo danneggerebbe subito e per sempre la nostra reputazione come fonte affidabile”.

Perché gli editor si sono sentiti esclusi

Oltre ai dubbi sulla qualità dei contenuti generati dall’intelligenza artificiale, molti redattori hanno lamentato di essere stati tagliati fuori dalla fase di progettazione del test.

Questa esclusione ha alimentato la frustrazione e aumentato la resistenza verso il progetto. Gli editor sono infatti il cuore pulsante di Wikipedia: senza il loro lavoro volontario la piattaforma non potrebbe esistere.

La decisione finale: stop al test dopo 24 ore

Il test è partito il 2 giugno 2025 ma è stato bloccato già il giorno successivo, il 3 giugno. La conferma è arrivata da fonti vicine a Wikimedia Foundation al sito 404 Media.

Un portavoce della fondazione ha spiegato così la scelta: “Ricevere feedback dai volontari è normale ed è proprio grazie a questi commenti se a volte cambiamo direzione”. Ha aggiunto che questa collaborazione con gli editor è ciò che rende Wikipedia una piattaforma davvero partecipativa.

Cosa ci insegna questa esperienza sull’uso dell’intelligenza artificiale nelle informazioni online

Il caso Wikipedia mostra quanto sia delicata l’integrazione dell’intelligenza artificiale nel mondo dell’informazione libera e collaborativa.

Da una parte c’è la voglia di innovare e velocizzare l’accesso ai contenuti; dall’altra c’è la necessità imprescindibile di mantenere alta la qualità e l’affidabilità delle informazioni.

Gli errori prodotti dall’IA possono avere conseguenze pesanti sulla fiducia degli utenti, soprattutto quando si parla di enciclopedie online usate da milioni ogni giorno per studiare o informarsi.

Il futuro dei contenuti generati dall’IA su piattaforme collaborative

Questa esperienza potrebbe spingere altre realtà simili a riflettere bene prima di adottare soluzioni automatiche senza coinvolgere chi lavora dietro le quinte.

L’equilibrio tra tecnologia e controllo umano resta fondamentale per garantire un’informazione corretta e trasparente.

Wikipedia rimane così uno specchio importante delle sfide attuali Nell’era digitale: innovare sì, ma senza perdere mai di vista la responsabilità verso chi legge.

Ultimo aggiornamento il 12 Giugno 2025 da Giulia Rinaldi